Produrre fantasmi (seconda parte)

Una storia sulle immagini che produciamo, e su quelle che ci producono.

Se vuoi leggere la prima parte di questa storia, la trovi qui:

Certe volte gli interruttori della luce non funzionano. Provi a spegnere la luce nella stanza in cui ti trovi, e quella non si spegne. Dopo vari tentativi inutili pensi di chiamare un elettricista per capire come risolvere, oppure decidi di prendere un bastone e distruggere il lampadario. Anche in quel caso la luce resta accesa: allora forse potrebbe essere che stai sognando. Nei sogni è così, quasi sempre: la luce non si spegne. Eppure di solito non è un grande problema che la luce non funzioni, come pure non prestiamo grande attenzione a quello che ci dicono gli orologi, o alle scritte in generale, o alle nostre mani, o agli specchi.

I reality check che qualcuno fa nei sogni lucidi servono proprio a scovare le distorsioni della realtà che lo circonda, e a capire che certe volte si tratta di una realtà onirica. Gli orologi digitali non vogliono dire mai niente; le nostre mani, a guardarle con attenzione, spesso hanno più o meno di cinque dita; se guardiamo in uno specchio è molto probabile che non vediamo alcuna immagine riflessa, o lo troviamo sporco, rotto, o alle brutte ci troviamo un’immagine di qualcun altro. E ancora, molto importante: in generale non si riesce a leggere mai nessuna scritta in un sogno: il titolo di un giornale, un’insegna, il tabellone dei treni, un segnale stradale. Qualunque scritta è messa nei sogni come un eterno Lorem Ipsum, perché tanto non abbiamo nessun bisogno di leggerla veramente. In realtà, ed è questo il punto forte, nei sogni noi non abbiamo bisogno di leggere sul serio praticamente niente: nemmeno le facce delle persone, o l’aspetto dei luoghi. E non ne abbiamo bisogno perché noi già sappiamo cosa c’è scritto: ce l’abbiamo scritto proprio noi (anche se forse inconsapevolmente). Quindi una scritta più o meno verosimile, nel posto giusto e del colore giusto, una persona che ti interroga ad una cattedra, un ragazzino poco più grande di te che ti ruba i giocattoli per dispetto, sono tutti elementi più che sufficienti per essere riempiti di significati e non pensarci più. E magari pensare ad altro, ad altri significati e collegamenti (forse a quello servono i sogni, non tanto a capire se si tratta di immagini vere o meno).

Nei sogni tutto è verosimile, fino a che non te lo metti ad analizzare veramente, nel dettaglio. A quel punto ti rendi conto che non torna quasi niente, che quella simulazione del mondo era solo approssimativa, o per qualche ragione illogica, stramba.

All’inizio di quest’anno ho iniziato a esplorare l’intelligenza artificiale generativa, in particolar modo i modelli che producono immagini. Ci sarebbero moltissime premesse da fare, me me ne concedo solo due: prima di tutto sto per parlare di qualcosa in costante e velocissima evoluzione, sia dal punto di vista della tecnologia che del nostro approccio e delle nostre reazioni ad essa, quindi forse si tratterà di un discorso da aggiornare tra poco. La seconda premessa riguarda quello che mi interessa per il momento dell’enorme potenziale delle AI, sia come osservatore che come autore, e cioè la soglia del verosimile. Non le immagini incredibili che riesce a fare, ma quelle credibili. Ok, premesse fatte, proseguiamo.

Davanti a delle immagini generate da AI tendiamo quasi sempre ad essere sorpresi per la verosimiglianza e a cercare subito qualcosa che la metta in crisi. Facciamo quasi subito dei reality check anche lì, come nei sogni. E spesso i punti dove casca l’asino sono incredibilmente gli stessi (in gergo si chiamano “allucinazioni“, davvero). Ad esempio, per moltissimo tempo - fino a pochi mesi fa - ogni volta che un modello tipo Midjourney, o DALL-E generava delle figure umane sbagliava quasi sempre le mani, che avevano spesso un numero di dita a caso. In molti casi questo non era un elemento determinante, perché magari l’immagine era pensata per raccontarti altro, non quante dita avessero i personaggi che la componevano. Ovviamente però faceva impressione, e attirava inevitabilmente l’attenzione.

Stessa cosa con i testi: ogni volta che vengono inseriti delle scritte come contesto in un’immagine non vogliono dire mai niente. In qualche caso riesci a distinguere alcuni caratteri, o a capire a quale stile o layout si è ispirato il modello (tipo il logo della Coca-Cola fatto male su un ombrellone di un bar: illeggibile, ma riconoscibile)

Insomma, l’intelligenza artificiale fa gli stessi “errori” che facciamo noi quando sogniamo. E di conseguenza mi viene da pensare e da dire, con una voce un po’ emotiva, che quando un modello generativo produce delle immagini in realtà le sta sognando; e che, insomma, stiamo costruendo macchine che ci sognano tutto il tempo. Lo so che non è vero, sicuramente non del tutto, però come vi sarete resi conto qui non stiamo parlando di verità.

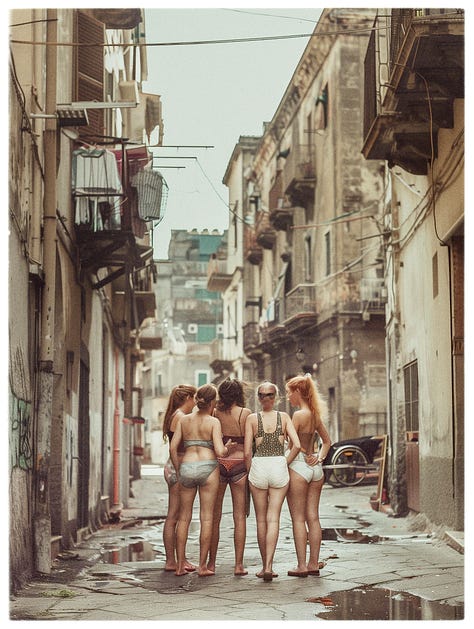

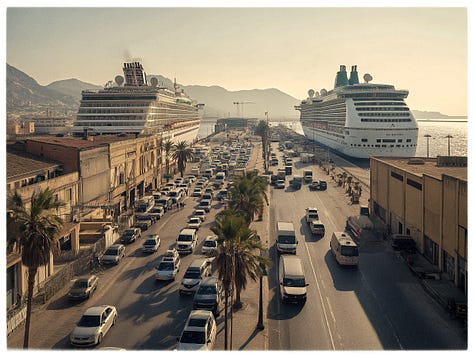

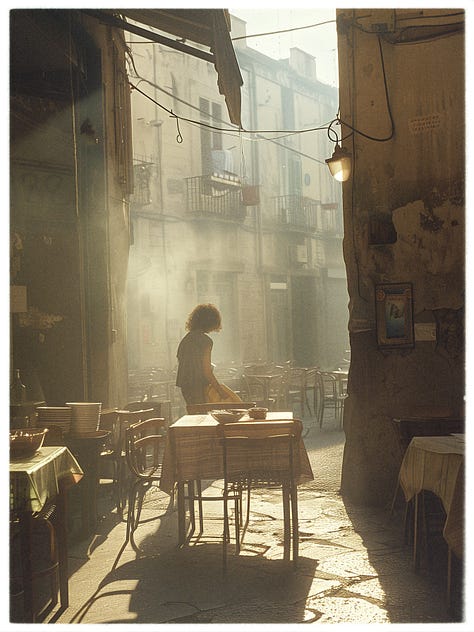

Adesso, andando sul pratico, quello che ho provato a fare in una prima fase è stato lavorare con l’immaginario di una città che mi sta facendo ammattire: Palermo. Detto brevemente ho generato delle immagini con una forte aspetto fotografico, partendo tra le altre cose proprio da fotografie di paesaggio urbano che ho scattato personalmente. Queste mie immagini di riferimento sono state utilizzate molto di più come ispirazione di stile e di struttura, che come base di contenuti. Per i contenuti infatti ho lavorato principalmente con istruzioni testuali.

In questa serie di immagini prodotte per Fantasma1, che si chiama “Palermo All You Can Heat”, ci stanno dentro molte questioni che ho spesso in testa quando mi guardo attorno, come l’over-tourism, la desertificazione (climatica e non), e in generale l’uso che facciamo dello spazio pubblico. Sono tutti temi che non vengono fuori in maniera sempre esplicita nelle immagini generate alla fine, ma sicuramente hanno contribuito quando dovevo dare una direzione alle cose.

Quello che è successo da Zines lo scorso settembre, è che le persone che ho incontrato, trovandosi di fronte a queste stampe, tentavano sempre spontaneamente di riconoscere il luogo che stavano vedendo. Inizialmente la questione che fossero immagini generate da una AI non era sul piatto. La questione centrale era invece dove fosse quel luogo lì. Da che punto hai scattato quella foto? Aspetta non me lo dire, lo so. E via dicendo. Tra coloro che avevano un immaginario piuttosto stratificato e solido sulla città di Palermo, cioè chi a Palermo ci abita o ci lavora o chi la frequenta abbastanza, in moltissimi stavano tentando di riconoscere il luogo che li circondava, senza riuscirci. E in effetti non era possibile riconoscere la città: quelle immagini proponevano viste inesistenti (e a volte distopiche) di spazi inventati - anche se perfettamente verosimili. Quello che le persone stavano facendo non era riconoscere Palermo, ma l’idea che avevano di Palermo. E questa cosa io non l’avevo capita così bene fino a che non ho assistito a quegli sguardi rassicurati e spaesati allo stesso tempo. E qui torniamo ai sogni.

In generale quello che succede in molte immagini generate artificialmente è sorprendentemente simile al mondo onirico: i modelli AI rielaborano, e riordinano tantissimi elementi visivi e semantici, lavorando su correlazioni e ricorrenze. Quello che ti restituiscono è un'immagine che è al tempo stesso familiare e inquietante, proprio come quelle dei sogni. I sogni tutto sommato, se hanno un compito, non è tanto quello di ricreare il mondo in maniera fedele, vera, ma solo plausibile. Poi il punto è che all’interno di quel mondo plausibile ci sono personaggi, spazi e cose a cui noi (il nostro inconscio) diamo una funzione. Tutto quello che si trova nei sogni ci “serve” come simbolo, e ogni cosa è una rappresentazione, non una riproduzione. Io sogno mio fratello che mi ruba i giochi, o la mia professoressa delle medie, ma entrambi per qualche ragione non avevano esattamente la loro faccia. Anzi certe volte non ci assomigliano proprio, certe altre a guardarli bene, non si riesce nemmeno a distinguerne veramente i tratti. Eppure è qualcosa a cui raramente ci troviamo a dare peso.

Tutto ciò, ad onor del vero, e forse ritorna la premessa, è un discorso estraneo a molte cose fatte con l’AI (ci sono moltissime immagini che puntano agli effetti speciali espliciti, e ad altre reazioni), ma sicuramente è centrale nel modo in cui la uso io. Le immagini che mi sono trovato a condividere funzionano fino a che non ti metti a guardarle con attenzione, proprio come succede nei sogni, dove su quel cartello non c’è scritto niente, io sto insieme ad una persona che in realtà non so chi sia, quelle auto vanno tutte contromano, quel palazzo non ha porte e finestre che si aprono. Tutto sembra ok, fino a che non ti chiedi che ci fai tu lì in mezzo, come ci sei arrivato. Ma, aspetta, stiamo parlando sempre del sogno?

Per qualche ragione tutto questo ha a che fare con come funziona la nostra visione del mondo. Ha a che fare con l’immaginario di cui disponiamo, individualmente e come società, dentro il quale andiamo a pescare il senso e il perché delle cose. È uno strumento potentissimo, quell’immaginario, perché ci consente di rappresentare la realtà anche senza avercela davanti, ma inevitabilmente non ci insegna niente che non conosciamo già. Perciò è importante nutrirlo, giocarci e metterlo in discussione.

Fantasma è un progetto editoriale. Produce cose che forse non esistono del tutto, ma a cui abbiamo deciso di credere. Volumi, stampe, audio.

Se hai voglia di condividere un'idea, o hai bisogno di informazioni:

www.edizionifantasma.it

spaziofantasma@gmail.com

Occhio:

Fantasma si occupa di contenuti e storie. Non si interessa esclusivamente di contenuti generati con modelli AI. È un progetto appena nato, con molto in cantiere, ma gestito ancora da una persona sola. Quindi abbiate pazienza se rispondo poco alla volta.